ML_2021_X-4 GPT的野望

GPT的任務

給定一個seq,要能預測出下一個出現的token是甚麼

ex. ground truth是台灣大學,則給定\\<BOS>、台,就要能預測灣

有點像transformer的decoder,只知道之前的內容。

因為GPT具備predict next token的能力,所以也可以用來做GAN

GPT的形象是獨角獸

How to use GPT

GPT也可以跟BERT用一樣的做法,拿出來用以後直接接一個簡單的classifier

原文論文不是這樣用(可能是fine-tune都有問題)

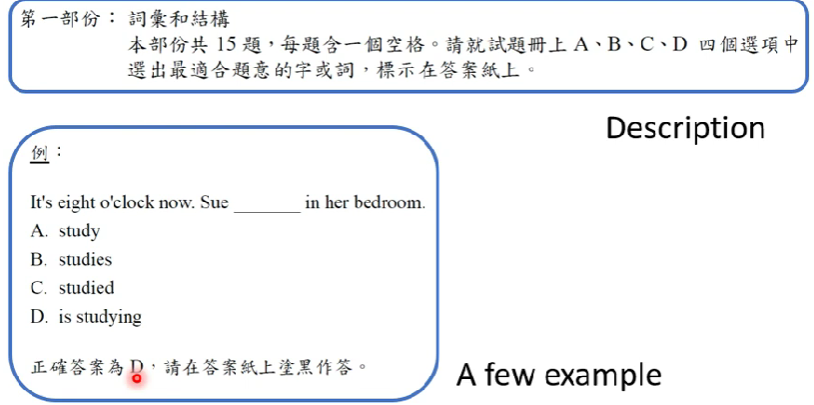

原文的訓練方式有點類似學測的模擬題目

給定樣本題與正確答案,希望他能做出類似的答案,也就是要能看懂題目要幹嘛,並給出答案從翻譯當例子,就是告訴它「Translate english to Chinese」(task description)後,再給幾個範例

- cheese -> 起司 (examples)

- sea -> 海洋

並叫它繼續填空- plush -> ___ (prompt)

- cheese -> 起司 (examples)

這樣的做法類似「few-shot learning」,但沒有用到gradient descent

- few-shot,表示給定的樣本數很少

- 原文作者給它命名為「in-context learning」

這種學法很有野心,但目前命中率不高(40~50%,175B parameters)

Beyond Text

除了剛剛的翻譯例子以外,GPT還有很多用途

在語音、CV等等領域也有所應用,留待深入研究

- BERT也可以做語音版的,語音也可以填空與預測

- 老師有帶領實驗室合作,開發相關的資料庫任務組:superb (語音版的GLUE)